Pioneiros da inteligência artificial ganham “Nobel” da computação

Os pesquisadores Andrew Barto e Richard Sutton venceram o Prêmio Turing por suas contribuições no desenvolvimento do aprendizado de reforço.

A Association for Computing Machinery (ACM), primeira sociedade científica dedicada à informática e ao desenvolvimento de computadores, anunciou na última quarta-feira (5) os vencedores do Prêmio Turing, tido como o Prêmio Nobel da computação. Pelo estabelecimento de uma técnica de Aprendizado de Máquina (Machine Learning) que treina agentes de tecnologia a tomar decisões, baseados em sistemas de recompensa, os cientistas de computação Andrew Barto e Richard Sutton levaram a distinção graças aos impactos da disciplina no desenvolvimento da inteligência artificial (IA). Além da honraria, ambos dividirão o prêmio de US$ 1 milhão.

Estabelecida por Barto em 1970, enquanto conduzia seus estudos na Universidade de Massachusetts Amherst, o conceito apoia-se no comportamento de neurônios humanos, que buscam sempre a maneira mais simples e fácil de atingir prazer e minimizar a dor. Com a chegada de Sutton à universidade, em 1978, o método foi revitalizado e passou a incluir a prática de tentativa e erro para encurtar o aprendizado das máquinas e acelerar o uso de aplicações mais complexas.

O sucesso do método ficou reservado ao âmbito acadêmico até 2016, data que a AlphaGo, pertencente a DeepMind do conglomerado Google, utilizou a tese para treinar seus modelos e derrotar os grandes campeões do jogo de tabuleiro chinês, famoso por ser um dos mais antigos em prática. O trunfo surpreendeu especialistas que acreditavam que o feito levaria mais de uma década para ser atingido. Graças ao sistema de recompensa e repetição, desenvolvido por Barto e Sutton, o modelo de inteligência artificial da Google superou o melhor jogador de Go dos últimos anos, Lee Sedol, e consolidou a eficácia da técnica.

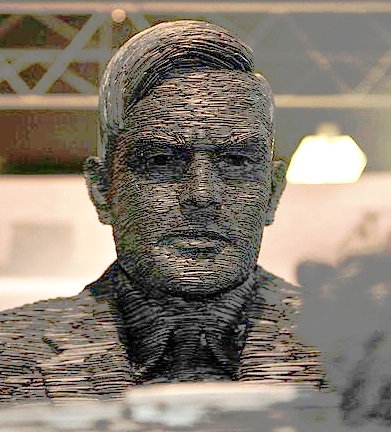

Andrew Barto e Richard Sutton levaram a distinção graças aos impactos da disciplina no desenvolvimento da inteligência artificial (IA). Foto: ACM

Não à toa, até para popularização da IA, em 2022, a OpenAI utilizou um método semelhante, operado por centenas de pessoas, para treinar chatbots. Com o que ficou conhecido como Reinforcement learning from human Feedback (RLHF), a modelo corrigiu erros, precisou respostas e otimizou seu desempenho no tempo de respostas, tornando o ChaGPT uma referência sobre a capacidade da IA generativa e preditivas nos primeiros capítulos da nova corrida pela inovação global.

Aprendizado de reforço: de olho no futuro

Ainda que a disciplina tenha se mostrado extremamente eficientes para treinar modelos e avançar o uso de novas soluções tecnologias, como as ferramentas de inteligência artificial, muitos especialistas ainda questionam a eficácia da metodologia para outros usos para além de sistemas fechados, como a lógica de jogos e Grandes Modelos de Linguagem (LLLMs). Em ambientes mais complexos, como aplicações de robótica, a metodologia precisa desenvolver outros mecanismos para treinar máquinas.

Em tempo, empresas já vêm demonstrando novidades derivadas da metodologia de aprendizagem de reforço. Nos últimos meses, a OpenAI e DeepSeek começaram a investir em sistema de raciocínio, disciplina que permite com que os chatbots das plataformas aprendam de maneira autônoma, destrinchando o método utilizado para construir uma frase, uma equação matemática ou uma previsão. Por meio dessa abordagem, a máquina aprende a imitar o raciocínio humano e assim simular respostas mais próximas das esperadas.

Na avaliação de Barto e Sutton, as novidades sugerem como as máquinas aprenderão no futuro e, eventualmente, serão a base para que robôs, equipados com IA, descubram como o mundo funciona à semelhança dos humanos. “Aprender a controlar um corpo por meio da aprendizagem por reforço é algo muito natural”, afirmou Barto.

comentários